大数据处理中的数据提取 关键概念与技术详解

在当今信息爆炸的时代,大数据处理已成为挖掘数据价值、驱动决策的核心环节。其中,数据提取作为整个数据处理流程的起点和基石,扮演着至关重要的角色。它是指从多种异构、分散的数据源中识别、收集和初步筛选出相关数据的过程,为后续的存储、清洗、分析和应用奠定基础。本文将深入解析大数据处理中数据提取的关键概念。

一、 数据提取的核心定义与目标

数据提取,有时也称作数据采集或数据获取,其核心目标是从一个或多个源头系统地获取数据,并将其转换为能够被后续系统处理和存储的格式。这些数据源可能包括:

1. 结构化数据源:如关系型数据库(MySQL, Oracle)、数据仓库中的表格。

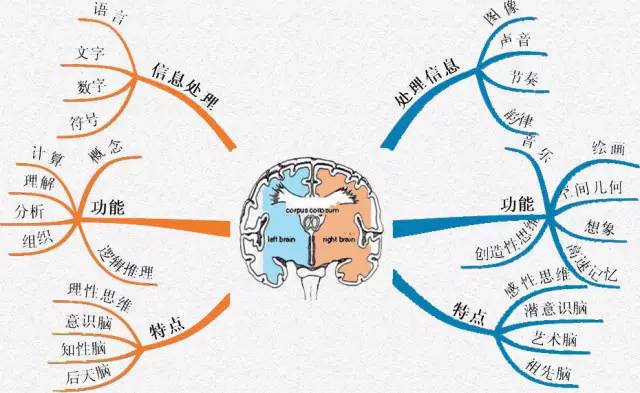

2. 半结构化数据源:如JSON、XML文件、网页、日志文件。

3. 非结构化数据源:如文本文档、图片、音频、视频。

4. 流数据源:如传感器实时数据、社交媒体信息流、在线交易记录。

其最终目的是构建一个统一、可靠的数据入口,确保下游分析所依赖的数据的完整性、准确性和时效性。

二、 关键概念详解

1. 数据源连接与适配

这是数据提取的第一步。关键技术包括使用API接口(如RESTful API)、数据库连接器(JDBC/ODBC)、网络爬虫、文件系统监听以及消息队列(如Kafka)等。适配器需要处理不同数据源的协议、认证和数据结构差异。

- 增量提取与全量提取

- 全量提取:首次或定期完整拷贝源数据。优点是实现简单,缺点是资源消耗大,对源系统压力大。

- 增量提取:仅捕获自上次提取以来发生变化的数据。关键技术包括基于时间戳、变更数据捕获(CDC)和日志跟踪等。它能显著提高效率,降低负载,是实现实时或近实时数据处理的基础。

3. ETL 与 ELT 流程中的“E”

在传统ETL(提取、转换、加载)中,数据在提取后通常会在专门的ETL服务器中进行转换,再加载到目标仓库。而在现代ELT(提取、加载、转换)模式中,数据被快速提取并原始地加载到高性能存储(如数据湖)中,转换工作在存储层后续进行。数据提取的策略需根据整体架构选择进行调整。

4. 数据抓取与爬取

针对网页等公开数据源,需要使用网络爬虫技术。这涉及页面下载、HTML解析、反爬虫策略应对(如遵守robots协议、设置合理间隔)以及动态内容的处理(如通过无头浏览器执行JavaScript)。

5. 流式数据提取

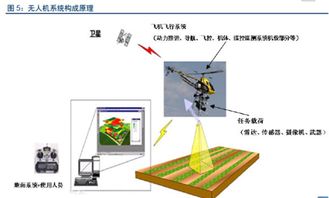

对于持续生成的数据流,提取过程必须是持续和低延迟的。这通常借助流处理框架(如Apache Flume, Apache NiFi, Spark Streaming)实现,它们能够实时摄取数据并将其导入流处理管道或存储系统。

6. 数据质量与元数据管理

在提取阶段就需关注数据质量。这包括记录数据来源、提取时间、数据格式等元数据,并进行初步的完整性检查(如关键字段是否缺失)和基础的一致性验证(如数据类型是否符合预期)。良好的元数据管理是数据可追溯性和可信度的保障。

7. 容错与可恢复性

大规模数据提取必须设计容错机制,处理网络中断、源系统不可用等异常。常见策略包括断点续传、失败重试、告警监控等,确保提取作业的鲁棒性。

三、 技术挑战与发展趋势

挑战主要包括:处理海量、高维、高速数据带来的性能压力;保障多源异构数据提取的一致性;应对源系统结构变更的适应性;以及在合规框架(如GDPR)下进行安全、合规的数据提取。

未来趋势体现在:

- 自动化与智能化:利用AI自动识别数据源模式、推荐提取策略、检测数据异常。

- 实时化:随着物联网和在线业务发展,对实时数据提取与处理的需求日益增长。

- 云原生与Serverless:基于云平台的数据提取服务(如AWS Glue, Azure Data Factory)提供了托管、可扩展的解决方案,降低了运维复杂度。

数据提取远非简单的数据搬运。它是一个融合了连接技术、增量策略、质量控制和容错设计的复杂过程。深入理解并优化数据提取环节,是构建高效、可靠大数据处理管道,最终实现数据价值最大化的关键第一步。

如若转载,请注明出处:http://www.jiayue118.com/product/76.html

更新时间:2026-02-25 11:05:09