Python爬虫与信息处理

Python爬虫与信息处理是当今数据驱动时代中至关重要的技术组合。通过Python编写的网络爬虫,可以高效地从互联网上采集大量数据,而信息处理技术则能对这些原始数据进行清洗、整理和分析,从而提取出有价值的信息。以下将分两部分详细介绍这两项技术及其应用。

一、Python爬虫技术

Python爬虫是指利用Python编程语言及相关库(如requests、BeautifulSoup、Scrapy等)自动抓取互联网上公开信息的技术。其核心步骤包括:发送HTTP请求获取网页内容、解析HTML结构提取目标数据,以及存储数据(如保存到文件或数据库)。Python爬虫的优势在于其简洁的语法和丰富的第三方库支持,使得开发者能够快速构建高效、可扩展的爬虫程序。常见应用场景包括:市场调研(抓取竞争对手价格)、新闻聚合(收集多个媒体头条)、学术研究(采集论文数据)等。使用爬虫时需遵守相关法律法规和网站robots.txt协议,避免过度请求导致服务器压力。

二、信息处理技术

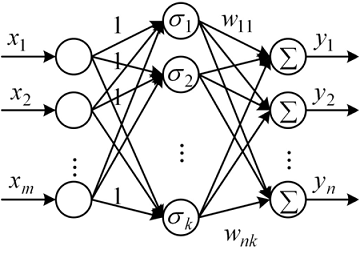

信息处理是指对采集到的原始数据(如文本、图片、视频等)进行清洗、转换、分析和可视化的过程。Python在这方面同样表现出色,常用库如Pandas用于数据清洗和处理、NumPy和SciPy用于科学计算、NLTK和spaCy用于自然语言处理、以及Matplotlib和Seaborn用于数据可视化。信息处理的关键步骤包括:数据预处理(去除噪声、处理缺失值)、特征提取(从数据中识别关键属性)、数据分析和建模(应用统计或机器学习方法发现模式)。例如,在电商领域,可通过信息处理技术分析用户评论的情感倾向,以优化产品策略;在金融领域,可处理交易数据以检测异常行为。

三、Python爬虫与信息处理的结合

在实际应用中,Python爬虫和信息处理往往是相辅相成的。爬虫负责数据的采集,而信息处理则赋予数据意义。例如,构建一个舆情监控系统:首先使用爬虫抓取社交媒体上的帖子,然后通过信息处理技术进行情感分析、主题分类和趋势预测,最终生成可视化报告。这种结合不仅提高了数据获取的效率,还增强了决策的准确性。对于初学者,建议从基础库如requests和Pandas入手,逐步掌握爬虫框架(如Scrapy)和高级分析工具(如Scikit-learn)。注意数据隐私和伦理问题,确保技术应用的合规性。

Python爬虫与信息处理是现代数据科学的核心技能,它们帮助我们从海量网络信息中挖掘洞见,推动业务创新和社会发展。通过持续学习和实践,开发者可以构建强大的数据管道,解决现实世界中的复杂问题。

如若转载,请注明出处:http://www.jiayue118.com/product/49.html

更新时间:2026-02-25 18:25:08